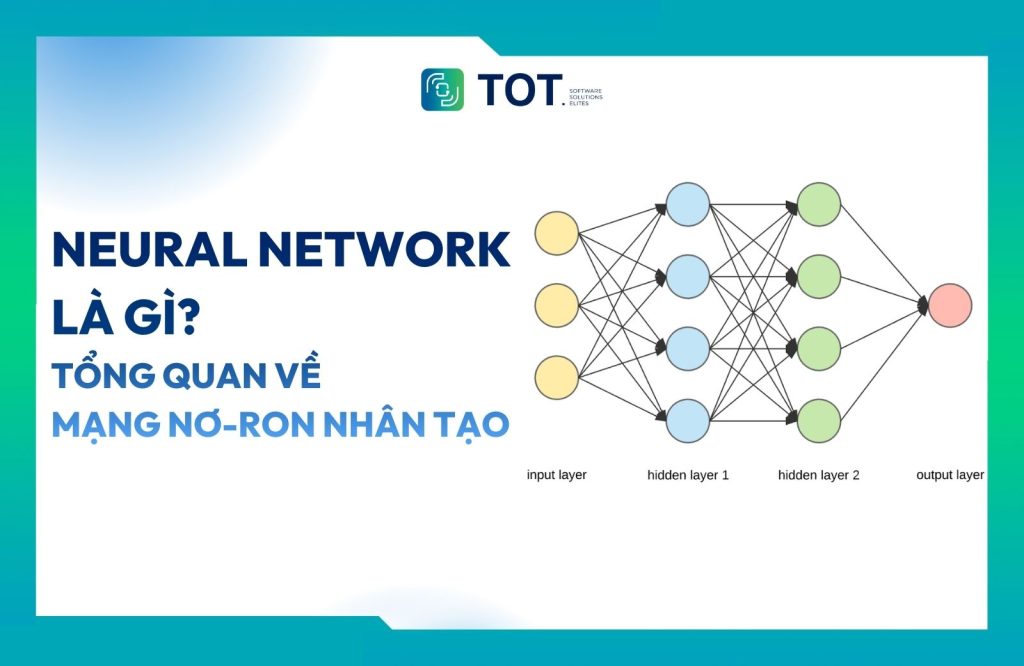

Neural Network (mạng nơ-ron nhân tạo) là một trong những nền tảng quan trọng của học máy hiện đại, được ứng dụng rộng rãi từ hệ thống gợi ý, chatbot đến tạo sinh văn bản. Từ những bài toán đơn giản ban đầu, mạng nơ-ron nhân tạo đã phát triển thành các kiến trúc quy mô lớn, đứng sau nhiều mô hình tiên tiến như mô hình YOLO hay GPT. Vậy Neural Network là gì, và vì sao chúng đóng vai trò cốt lõi trong sự phát triển của các hệ thống trí tuệ nhân tạo hiện nay? Hãy cùng tìm hiểu chi tiết qua bài viết sau.

>>> Tìm hiểu thêm

- Vertex AI là gì? Nền tảng học máy của Google Cloud

- Object Detection Models: Các mô hình phát hiện đối tượng tốt nhất

- Xây Dựng Mô Hình Ngôn Ngữ Thị Giác với Next.js & Roboflow

- Cách tạo chatbot AI bán hàng đa kênh hiệu quả, chi tiết

Mở đầu

Việc phát triển Neural Network (mạng nơ-ron nhân tạo) là một lĩnh vực nghiên cứu sôi động, khi các nhà khoa học và doanh nghiệp liên tục tìm kiếm những phương pháp hiệu quả hơn để giải quyết các bài toán phức tạp bằng học máy (machine learning).

Mạng nơ-ron nhân tạo lần đầu tiên được đề xuất vào năm 1944 bởi Warren McCullough và Walter Pitts, hai nhà nghiên cứu thuộc Đại học Chicago. Sau đó, họ chuyển đến MIT vào năm 1952 và công bố công trình “Một phép tính logic về các ý tưởng tiềm ẩn trong hoạt động thần kinh”.

Ban đầu, mạng nơ-ron nhân tạo chỉ được sử dụng cho các tác vụ đơn giản như nhận diện thư rác. Tuy nhiên, theo thời gian, phạm vi ứng dụng của chúng đã mở rộng sang những nhiệm vụ phức tạp hơn, bao gồm công cụ tìm kiếm hình ảnh, hệ thống gợi ý, chatbot và cả lĩnh vực y tế. Trên thực tế, mạng nơ-ron nhân tạo hiện diện trong rất nhiều ứng dụng quen thuộc, từ việc đề xuất nội dung trên Netflix cho đến việc tạo sinh văn bản.

Cùng với sự phát triển đó, mạng nơ-ron nhân tạo đã tiến hóa từ những kiến trúc sơ khai chỉ xử lý được lượng dữ liệu hạn chế, sang các kiến trúc quy mô lớn với hàng triệu tham số được huấn luyện trên các tập dữ liệu khổng lồ. Ở trung tâm của những mô hình tiên tiến hàng đầu hiện nay, từ YOLO đến GPT, đều là mạng nơ-ron nhân tạo.

Chúng ta sẽ cùng tìm hiểu Neural Network là gì, cách hoạt động của chúng và các kiến trúc mạng nơ ron chi tiết qua bài viết sau.

>>> Tham khảo:

- AI Data Labeling: Hướng dẫn gán nhãn dữ Liệu AI

- Predictive AI là gì? Cách AI dự đoán hành vi và xu hướng tương lai

Neural Network là gì?

Neural Network còn gọi là mạng nơ-ron nhân tạo, đây cấu trúc được tạo thành từ các đơn vị gọi là “nơ-ron”, được sắp xếp thành nhiều lớp. Các nơ-ron sử dụng các hàm toán học để quyết định liệu chúng có được “kích hoạt” và truyền thông tin sang lớp nơ-ron tiếp theo hay không.

Kiến trúc của mạng nơ-ron nhân tạo được thiết kế tương tự như bộ não con người, nơi các nơ-ron kích hoạt và hình thành các kết nối với những nơ-ron khác. Nhờ đó, mạng nơ-ron nhân tạo có thể được sử dụng để giải quyết nhiều bài toán phức tạp, từ tạo sinh hình ảnh cho đến việc phát hiện đối tượng (Object Detection) trong hình ảnh.

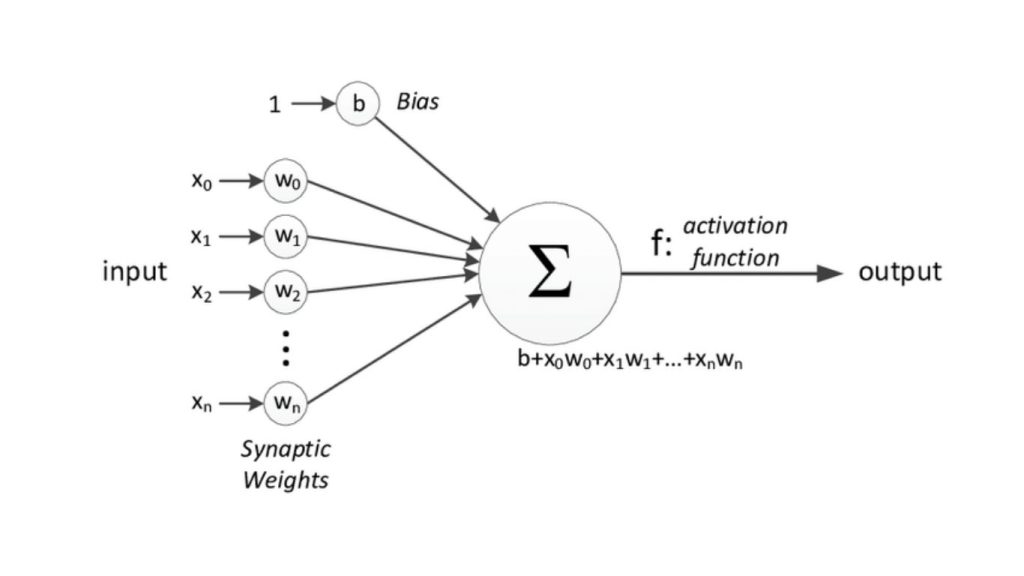

Trong một mạng nơ-ron nhân tạo, dữ liệu được đưa vào và truyền qua nhiều lớp nơ-ron nhân tạo để tạo ra đầu ra mong muốn. Mỗi nơ-ron bao gồm nhiều thành phần khác nhau, như được minh họa trong hình bên dưới:

>> Tìm hiểu thêm:

- Xây dựng ứng dụng phát hiện đối tượng bằng Python chỉ trong vài phút với Roboflow

- AI nhận diện ảnh là gì? Thuật toán và ứng dụng phổ biến

Các đặc điểm của một nơ-ron

Mỗi nơ-ron có bốn đặc điểm chính như sau:

Đầu vào (Input)

Các đặc trưng được đưa vào mô hình trong quá trình học được gọi là đầu vào. Ví dụ, trong bài toán phát hiện đối tượng, đầu vào có thể là một mảng các giá trị pixel của hình ảnh.

Trọng số (Weights)

Các trọng số được sử dụng để nhấn mạnh các “đặc trưng” có ảnh hưởng lớn hơn đến quá trình học. Một đặc trưng càng thường xuyên xuất hiện trong các dự đoán chính xác của mạng thì nơ-ron (hoặc các nơ-ron) đại diện cho đặc trưng đó sẽ được gán trọng số càng cao. Trọng số được tính bằng cách áp dụng phép nhân vô hướng giữa giá trị đầu vào và ma trận trọng số.

Ví dụ, trong một mô hình phân tích cảm xúc nhằm nhận diện các từ mang sắc thái tiêu cực, một từ có ý nghĩa tiêu cực sẽ ảnh hưởng đến kết quả nhiều hơn so với một cặp từ trung tính.

Hàm kích hoạt (Activation Function)

Mục đích chính của hàm kích hoạt là biến đổi tổng các đầu vào có trọng số từ một nút thành một giá trị đầu ra được truyền sang lớp ẩn tiếp theo hoặc được sử dụng làm đầu ra cuối cùng.

Các hàm kích hoạt quyết định liệu một nơ-ron có nên được kích hoạt hay không dựa trên đầu vào của nó trong mạng. Những hàm này sử dụng các phép toán toán học để xác định mức độ quan trọng của đầu vào đối với việc dự đoán. Nếu đầu vào được xem là quan trọng, hàm sẽ “kích hoạt” nơ-ron.

Phần lớn các hàm kích hoạt đều là phi tuyến tính. Điều này cho phép mạng nơ-ron nhân tạo “học” được những đặc trưng phức tạp trong tập dữ liệu, chẳng hạn như cách các pixel khác nhau kết hợp để tạo thành một đặc trưng trong hình ảnh. Nếu không có các hàm kích hoạt phi tuyến, mạng nơ-ron nhân tạo chỉ có thể học các hàm tuyến tính và hàm bậc hai, trong khi các hàm này không thể mô tả được những mẫu hình phức tạp và phi tuyến thường xuất hiện trong dữ liệu thực tế.

Độ chệch (Bias)

Độ chệch là thuật ngữ dùng để chỉ các tham số của một nơ-ron được cộng vào tổng có trọng số của các đầu vào trước khi đi qua hàm kích hoạt. Độ chệch thường được biểu diễn dưới dạng một giá trị vô hướng và được học trong quá trình huấn luyện mạng nơ-ron nhân tạo, cùng với các trọng số.

Các thành phần của độ chệch có thể làm thay đổi đầu ra của nơ-ron bằng cách dịch chuyển hàm kích hoạt sang trái hoặc sang phải. Điều này dẫn đến sự thay đổi trong phạm vi giá trị đầu ra và số lượng nơ-ron được kích hoạt, từ đó có thể ảnh hưởng đáng kể đến hành vi tổng thể của toàn bộ mạng.

>> Xem thêm:

- Vision AI Agents là gì? Cách xây dựng Vision AI Agents với Roboflow

- Các công cụ thị giác máy tính tốt nhất: Lời khuyên về các thư viện tốt nhất & nhiều hơn nữa

Tại sao mạng nơ-ron nhân tạo lại quan trọng?

Mạng nơ-ron nhân tạo là nền tảng cốt lõi của học máy hiện đại nhờ khả năng mô hình hóa các mối quan hệ phức tạp và phi tuyến tính trong dữ liệu. Khác với các thuật toán truyền thống vốn phụ thuộc vào việc lập trình cụ thể cho từng tác vụ, mạng nơ-ron nhân tạo có thể tự học cách thực hiện nhiều tác vụ khác nhau, chẳng hạn như nhận dạng hình ảnh, xử lý ngôn ngữ tự nhiên và xây dựng các mô hình dự đoán.

Ví dụ, trong bài toán nhận dạng hình ảnh, một mạng nơ-ron nhân tạo có thể nhận biết rằng một bức ảnh chụp con chó dưới ánh sáng mạnh và một bức ảnh chụp con chó trong điều kiện ánh sáng yếu đều cùng đại diện cho “con chó”, bất chấp sự khác biệt về ánh sáng, góc chụp hay bối cảnh nền.

Khả năng thích nghi và liên tục cải thiện khi được tiếp xúc với nhiều dữ liệu hơn giúp mạng nơ-ron nhân tạo trở nên vô cùng linh hoạt trong nhiều lĩnh vực ứng dụng, từ thị giác máy tính (Computer Vision) và xử lý ngôn ngữ tự nhiên (NLP – Natural Language Processing) cho đến phân tích dự đoán và phát hiện bất thường.

Neural Network hoạt động như thế nào?

Mạng nơ-ron nhân tạo có sự đa dạng rất lớn. Mỗi ngày, các nhà nghiên cứu trong doanh nghiệp và học thuật trên khắp thế giới đều đang thử nghiệm những cấu hình mạng nơ-ron nhân tạo mới nhằm giải quyết cùng một bài toán hiệu quả hơn so với các phiên bản trước đó. Tuy nhiên, xét trên phương diện tổng quát, các mạng nơ-ron nhân tạo có một số đặc điểm chung.

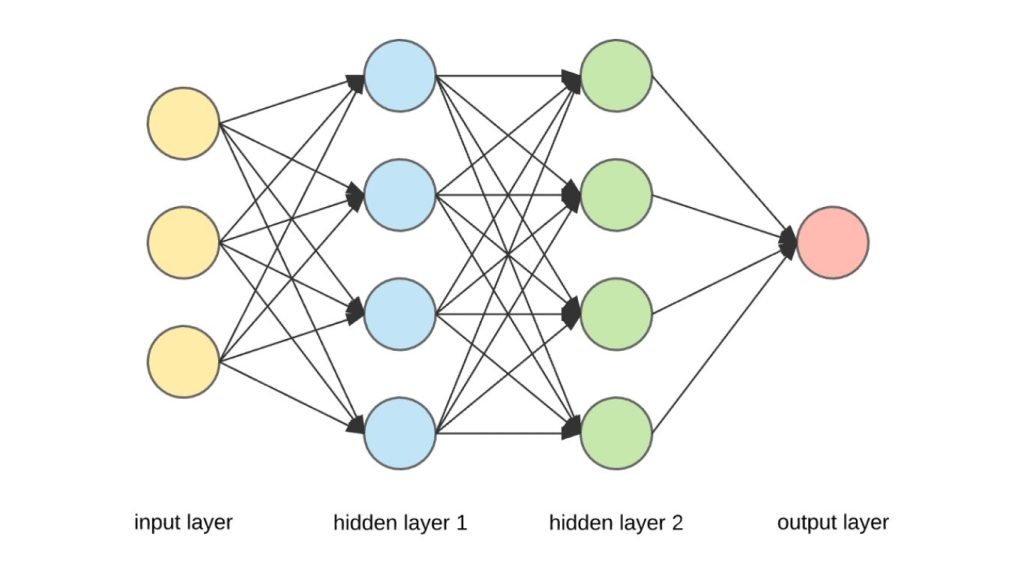

Hình ảnh dưới đây minh họa cấu trúc tổng quát của một mạng nơ-ron nhân tạo, bao gồm lớp đầu vào (input layer), các lớp ẩn (hidden layers) và lớp đầu ra (output layer):

Lớp đầu vào

Lớp đầu vào của mạng nơ-ron nhân tạo có nhiệm vụ tiếp nhận dữ liệu. Dữ liệu này thường đã được xử lý từ các nguồn như hình ảnh hoặc dữ liệu dạng bảng và được chuyển đổi sang một cấu trúc mà mạng có thể hiểu. Đây là lớp duy nhất có thể quan sát trực tiếp trong toàn bộ kiến trúc mạng nơ-ron nhân tạo. Lớp đầu vào chỉ truyền dữ liệu thô đi mà không thực hiện bất kỳ phép tính nào.

Lớp ẩn

Các lớp ẩn (như được minh họa trong hình trên) là nền tảng của học sâu (Deep Learning). Đây là các lớp trung gian thực hiện các phép tính và trích xuất đặc trưng từ dữ liệu. Một mạng có thể bao gồm nhiều lớp ẩn được kết nối với nhau, trong đó mỗi lớp đảm nhiệm việc nhận diện những đặc trưng khác nhau của dữ liệu.

Ví dụ, trong xử lý hình ảnh, các lớp ẩn ở giai đoạn đầu có thể phát hiện những đặc trưng mức cao như cạnh, hình dạng hoặc ranh giới. Trong khi đó, các lớp phía sau thực hiện những nhiệm vụ phức tạp hơn, chẳng hạn như nhận diện các đối tượng hoàn chỉnh như ô tô, tòa nhà hoặc con người.

Lớp đầu ra

Lớp đầu ra nhận đầu vào từ các lớp ẩn trước đó và tạo ra dự đoán cuối cùng dựa trên thông tin mà mô hình đã học được. Trong các mô hình phân loại/đại diện, lớp đầu ra thường chỉ có một nút. Tuy nhiên, số lượng nút có thể thay đổi tùy thuộc vào loại vấn đề cụ thể đang được giải quyết và cách mô hình được xây dựng.

>> Tham khảo thêm:

- Cách ứng dụng AI tối ưu trải nghiệm khách hàng

- Hướng dẫn triển khai AI trong ứng dụng di động đơn giản

Các kiến trúc mạng nơ-ron nhân tạo

Một trong những yếu tố then chốt quyết định sự thành công của mạng nơ-ron nhân tạo chính là kiến trúc của mạng, vì kiến trúc này xác định cách mạng xử lý và diễn giải thông tin.

Trong phần này, chúng ta sẽ thảo luận về một số kiến trúc mạng nơ-ron nhân tạo phổ biến nhất và các ứng dụng của chúng, bao gồm:

- Perceptron

- Feedforward neural network (Mạng nơ-ron truyền thẳng)

- Residual networks (Mạng nơ-ron dư)

- LTSM networks (Mạng LSTM)

- Convolutional neural networks (Mạng nơ-ron tích chập)

- Recurrent neural networks (Mạng nơ-ron hồi quy).

Việc hiểu rõ các kiến trúc khác nhau cùng với điểm mạnh và hạn chế của chúng là vô cùng quan trọng để lựa chọn mạng phù hợp cho từng bài toán cụ thể, đạt được hiệu suất tối ưu, đồng thời giúp bạn hình dung một cách trực quan quá trình phát triển dẫn đến các mạng nơ-ron hiện đại ngày nay.

Perceptron

Perceptron là kiến trúc mạng nơ-ron nhân tạo cơ bản nhất. Perceptron nhận nhiều đầu vào, thực hiện các phép toán trên chúng và tạo ra đầu ra.

Perceptron tiếp nhận một vector các giá trị đầu vào thực, thực hiện tổ hợp tuyến tính giữa mỗi đầu vào và trọng số tương ứng của nó, cộng tổng các giá trị đã được gán trọng số, sau đó đưa kết quả đi qua một hàm kích hoạt. Các đơn vị perceptron có thể được kết hợp lại để tạo thành những kiến trúc mạng nơ-ron nhân tạo phức tạp hơn.

Mạng nơ-ron truyền thẳng

Một Perceptron mô phỏng hành vi của một nơ-ron đơn lẻ. Khi nhiều perceptron được sắp xếp theo chuỗi và tổ chức thành các lớp, chúng tạo thành một mạng nơ-ron nhân tạo đa lớp.

Trong kiến trúc mạng nơ-ron truyền thẳng, thông tin chỉ truyền theo một chiều tiến về phía trước, từ trái sang phải, bắt đầu từ lớp đầu vào, đi qua nhiều lớp ẩn và cuối cùng đến lớp đầu ra. Loại mạng này được gọi là mạng nơ ron truyền thẳng vì thông tin không quay ngược trở lại giữa các lớp ẩn. Các lớp phía sau không cung cấp phản hồi cho các lớp phía trước, tức là quá trình học chỉ diễn ra theo một chiều. Cơ chế học vẫn tương tự như perceptron.

>> Tham khảo thêm: Suy Luận Trong Thị Giác Máy Tính: Cách Thực Hiện & Triển Khai Mô Hình AI

Mạng nơ-ron dư

Sau khi đã biết một ít về mạng nơ-ron truyền thẳng, bạn có thể tự hỏi “làm thế nào để xác định số lượng lớp trong một kiến trúc mạng nơ-ron nhân tạo?”

Một quan niệm sai lầm phổ biến là càng sử dụng nhiều lớp ẩn thì quá trình học càng tốt. Tuy nhiên, điều này không phải lúc nào cũng đúng. Các mạng nơ-ron có quá nhiều lớp có thể rất khó huấn luyện do gặp phải các vấn đề như gradient tiêu biến (vanishing gradient) và gradient bùng nổ (exploding gradient).

Một cách tiếp cận để giải quyết các vấn đề này là sử dụng mạng nơ-ron dư. Không giống như mạng truyền thẳng truyền thống, Mạng nơ-ron dư cung cấp một đường đi thay thế cho luồng dữ liệu, giúp quá trình huấn luyện trở nên nhanh hơn và dễ dàng hơn.

Mạng nơ-ron dư được thiết kế dựa trên lý thuyết rằng một mạng sâu có thể được xây dựng từ một mạng nông hơn bằng cách sao chép trọng số từ mạng nông thông qua ánh xạ đồng nhất. Dữ liệu từ các lớp trước được “chuyển tiếp nhanh” và truyền qua mạng thông qua các kết nối tắt (skip connection). Những kết nối này lần đầu tiên được giới thiệu trong mạng nơ-ron dư nhằm giúp giải quyết vấn đề gradient tiêu biến.

>> Xem thêm: LLM là gì? Mô hình ngôn ngữ lớn và cách chúng hoạt động

Mạng nơ-ron hồi quy

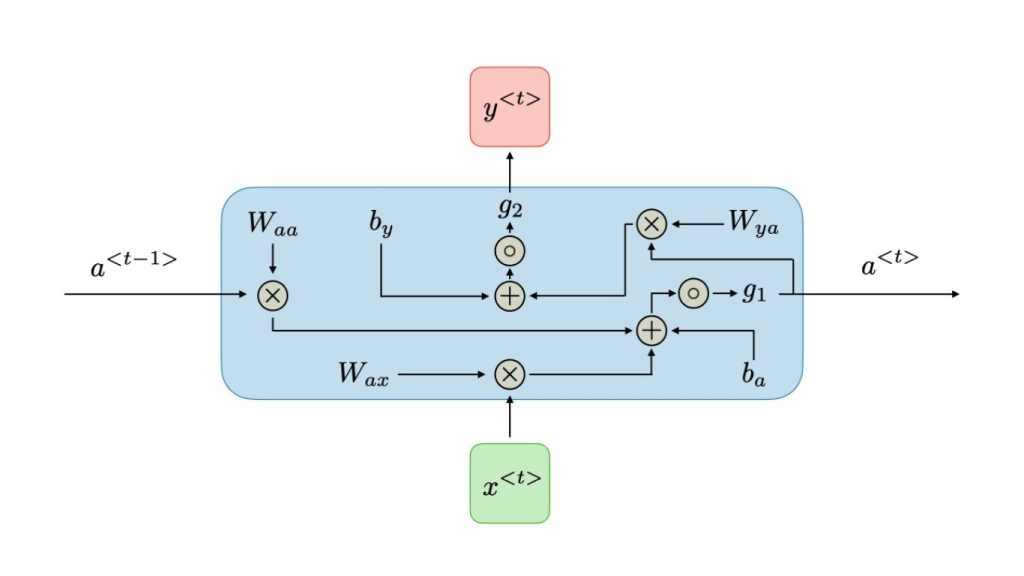

Các kiến trúc học sâu truyền thống thường có kích thước đầu vào cố định, điều này trở thành hạn chế trong những trường hợp mà kích thước đầu vào không cố định. Ngoài ra, các mô hình này chỉ đưa ra quyết định dựa trên đầu vào hiện tại mà không xét đến các đầu vào trước đó.

Mạng nơ-ron hồi quy (RNNs) đặc biệt phù hợp để xử lý dữ liệu đầu vào dạng chuỗi. Chúng hoạt động rất hiệu quả trong các tác vụ xử lý ngôn ngữ tự nhiên (NLP) như phân tích cảm xúc và bộ lọc thư rác, cũng như các bài toán chuỗi thời gian như dự báo doanh số và dự đoán thị trường chứng khoán. RNNs có khả năng “ghi nhớ” các đầu vào trước đó và sử dụng thông tin này để hỗ trợ các dự đoán trong tương lai.

Trong RNN, dữ liệu tuần tự được đưa vào làm đầu vào. Mạng có một trạng thái ẩn nội bộ được cập nhật sau mỗi chuỗi đầu vào mới. Trạng thái ẩn này được đưa ngược trở lại mô hình và tạo ra một đầu ra tại mỗi mốc thời gian.

Tại mỗi mốc thời gian, mạng nhận một chuỗi đầu vào mới và cập nhật trạng thái ẩn dựa trên cả đầu vào mới lẫn trạng thái ẩn hiện tại của nó. Trạng thái ẩn được cập nhật này sau đó được sử dụng để tạo ra đầu ra, có thể là một dự đoán, một phân loại hoặc một quyết định nào đó.

Mốc thời gian đề cập đến thứ tự mà các chuỗi đầu vào được đưa vào mạng. Trong một số ứng dụng như xử lý ngôn ngữ tự nhiên, mốc thời gian có thể tương ứng với vị trí của một từ trong câu. Trong các ứng dụng khác như dự báo chuỗi thời gian, mốc thời gian có thể tương ứng với một thời điểm cụ thể.

Trạng thái ẩn bên trong được đưa ngược trở lại mô hình tại mỗi mốc thời gian, nghĩa là trạng thái ẩn của bước thời gian trước được truyền sang bước thời gian hiện tại để đưa ra dự đoán hoặc quyết định. Điều này cho phép mạng duy trì một dạng “bộ nhớ” về các đầu vào trong quá khứ và sử dụng thông tin đó cho đầu ra hiện tại.

>> Xem thêm: Phân tích hình ảnh bằng AI là gì? Cách AI hiểu và diễn giải hình ảnh

Mạng nơ-ron bộ nhớ ngắn hạn – dài hạn (LSTM)

Trong các RNN truyền thống, mỗi dự đoán chỉ dựa trên mốc thời gian trước đó và khả năng ghi nhớ ngắn hạn là rất hạn chế. Mô hình không xem xét được thông tin từ những thời điểm xa hơn trong quá khứ. Để cải thiện điều này, chúng ta có thể mở rộng cấu trúc RNN bằng cách tích hợp vào khái niệm “bộ nhớ”.

Điều này được thực hiện bằng cách bổ sung các thành phần gọi là “cổng” vào cấu trúc mạng. Các cổng này cho phép mạng ghi nhớ thông tin từ các mốc thời gian trước đó, giúp nó có khả năng ghi nhớ lâu hơn.

- Cell state (Bộ nhớ ô): Ký hiệu là cₜ, đại diện cho bộ nhớ dài hạn của mạng.

- Forget gate (Cổng quên): Có nhiệm vụ loại bỏ những thông tin trong bộ nhớ ô không còn hữu ích. Nó nhận hai đầu vào là đầu vào tại mốc thời gian hiện tại (xₜ) và trạng thái ẩn của mốc thời gian trước đó (hₜ₋₁), nhân chúng với các ma trận trọng số tương ứng rồi cộng thêm độ lệch. Kết quả được đưa qua một hàm kích hoạt để tạo ra giá trị nhị phân, quyết định thông tin nào được giữ lại hoặc bị loại bỏ.

- Input gate (Cổng đầu vào): Là nơi chọn lọc những thông tin mới cần được thêm vào bộ nhớ ô. Nó hoạt động tương tự như cổng quên nhưng sử dụng một bộ trọng số riêng.

- Output gate (Cổng đầu ra): Mục đích của cổng đầu ra là xác định thông tin liên quan từ bộ nhớ ô hiện tại và xuất thông tin ra ngoài dưới dạng đầu ra.

>> Xem thêm: Foundation Model là gì? Các loại mô hình nền tảng và ứng dụng trong AI

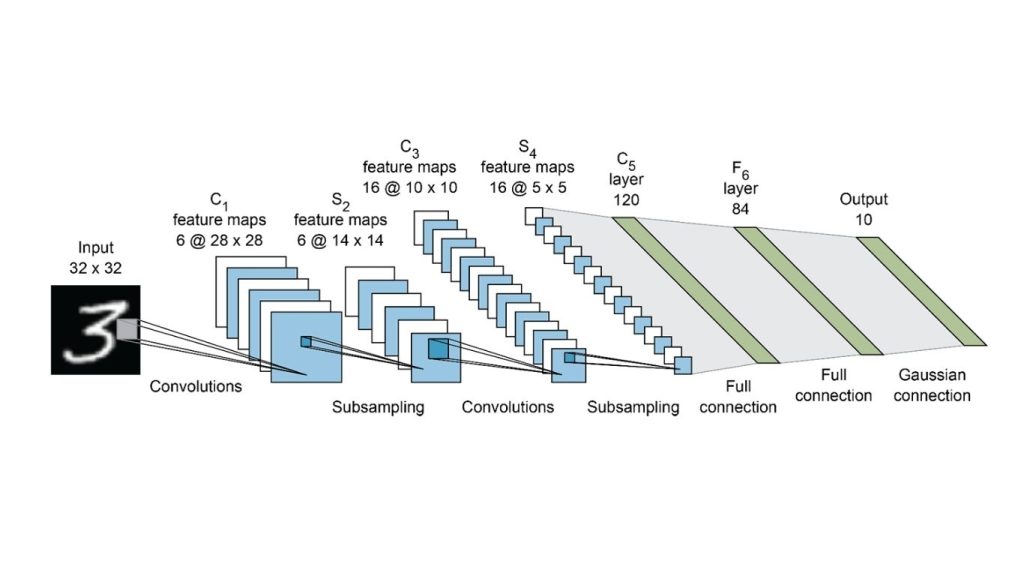

Mạng nơ-ron tích chập (CNNs)

CNNs là một dạng mạng nơ-ron truyền thẳng, thường được sử dụng cho các nhiệm vụ như phân tích hình ảnh, xử lý ngôn ngữ tự nhiên và các bài toán phân loại hình ảnh phức tạp.

CNNs bao gồm các lớp ẩn được gọi là lớp tích chập (convolutional layers), đóng vai trò nền tảng của mạng. Trong dữ liệu hình ảnh, các đặc trưng có thể là những chi tiết nhỏ như cạnh, viền, hình dạng, kết cấu, đối tượng, hình tròn,…

Các lớp tích chập trong CNN sử dụng bộ lọc để phát hiện các mẫu này trong dữ liệu hình ảnh. Các lớp dưới tập trung vào các đặc trưng đơn giản, trong khi các lớp sâu hơn có khả năng phát hiện các đặc trưng và đối tượng phức tạp hơn. Ví dụ, ở các lớp sau, bộ lọc có thể phát hiện những đối tượng cụ thể như mắt hoặc tai, và cuối cùng là các đối tượng hoàn chỉnh như mèo hoặc chó.

Khi thêm một lớp tích chập vào mạng, trước hết cần xác định số lượng bộ lọc. Mỗi bộ lọc có thể được hình dung như một ma trận nhỏ, với số hàng và số cột được lựa chọn sẵn. Các giá trị trong ma trận đặc trưng này được khởi tạo ngẫu nhiên.

Khi lớp tích chập nhận các giá trị pixel từ dữ liệu đầu vào, bộ lọc sẽ thực hiện phép tích chập trên từng vùng của ma trận đầu vào. Đầu ra của lớp tích chập thường được đưa qua hàm kích hoạt ReLU, nhằm đưa tính phi tuyến vào mô hình bằng cách đặt tất cả các giá trị âm về 0.

Pooling là một bước quan trọng trong CNN vì nó giúp giảm khối lượng tính toán và làm cho mô hình ổn định hơn trước các biến dạng và sự thay đổi của dữ liệu. Sau đó, một mạng nơ-ron nhân tạo kết nối đầy đủ sẽ sử dụng ma trận đặc trưng đã được làm phẳng để đưa ra dự đoán, tùy thuộc vào từng bài toán cụ thể.

>> Xem thêm: Convolutional Neural Network là gì? Tổng quan về mạng nơ-ron tích chập

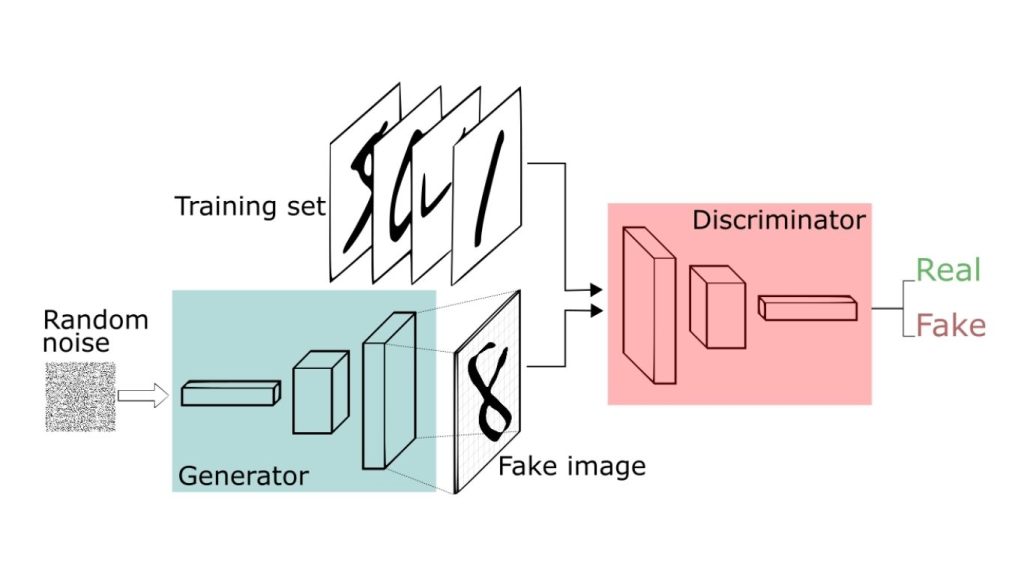

Mạng đối kháng sinh thành (GAN)

Mô hình sinh thành (Generative modeling) là một nhánh con của học không giám sát, trong đó dữ liệu mới hoặc dữ liệu tổng hợp được tạo ra dựa trên các mẫu được học từ một tập dữ liệu đầu vào. Mạng đối kháng sinh thành là một loại mô hình sinh có khả năng tạo ra dữ liệu tổng hợp hoàn toàn mới bằng cách học các mẫu trong dữ liệu đầu vào. GAN là một lĩnh vực phổ biến và đang được nghiên cứu rất tích cực trong trí tuệ nhân tạo.

GAN bao gồm hai thành phần: bộ sinh (generator) và bộ phân biệt (discriminator) , hoạt động theo cơ chế cạnh tranh. Bộ sinh chịu trách nhiệm tạo ra dữ liệu tổng hợp dựa trên các đặc trưng mà nó đã học được trong quá trình huấn luyện. Bộ sinh nhận dữ liệu ngẫu nhiên làm đầu vào và tạo ra một hình ảnh sinh thành sau khi thực hiện một số phép biến đổi nhất định. Bộ phân biệt đóng vai trò như một bộ đánh giá, có hiểu biết tổng quát về miền bài toán cũng như khả năng nhận diện các hình ảnh do bộ sinh tạo ra.

Bộ sinh tạo ra hình ảnh, còn bộ phân biệt phân loại các hình ảnh đó là giả hay thật. Bộ phân biệt đưa ra một dự đoán xác suất trong khoảng từ 0 đến 1, trong đó 1 – biểu thị hình ảnh thật và 0 – biểu thị hình ảnh giả. Bộ sinh liên tục tạo ra các mẫu dữ liệu, trong khi bộ phân biệt cố gắng phân biệt giữa các mẫu từ dữ liệu huấn luyện và các mẫu do bộ sinh tạo ra. Bộ sinh nhận phản hồi từ bộ phân biệt để cải thiện khả năng sinh dữ liệu của mình.

Khi bộ phân biệt xác định chính xác các mẫu thật và giả, các tham số của nó không cần phải điều chỉnh. Bộ sinh sẽ bị phạt khi không tạo ra được các hình ảnh đủ thuyết phục để đánh lừa bộ phân biệt. Ngược lại, nếu bộ sinh thành công trong việc khiến bộ phân biệt phân loại hình ảnh sinh thành là thật, điều đó cho thấy quá trình huấn luyện của bộ sinh đang diễn ra hiệu quả. Mục tiêu cuối cùng của bộ sinh là đánh lừa bộ phân biệt, trong khi mục tiêu của bộ phân biệt là nâng cao độ chính xác phân loại.

GAN được ứng dụng trong nhiều lĩnh vực khác nhau như dự đoán khung hình tiếp theo trong video, sinh ảnh từ văn bản, chuyển đổi hình ảnh sang hình ảnh, khử nhiễu hình ảnh và nhiều ứng dụng khác.

Transformers

Việc huấn luyện RNN và LSTM có thể chậm và kém hiệu quả, đặc biệt khi xử lý dữ liệu chuỗi lớn và gặp phải vấn đề gradient tiêu biến. Một trong những nguyên nhân là dữ liệu phải được đưa vào theo trình tự, khiến việc tận dụng tối đa khả năng xử lý của GPU trở nên khó khăn.

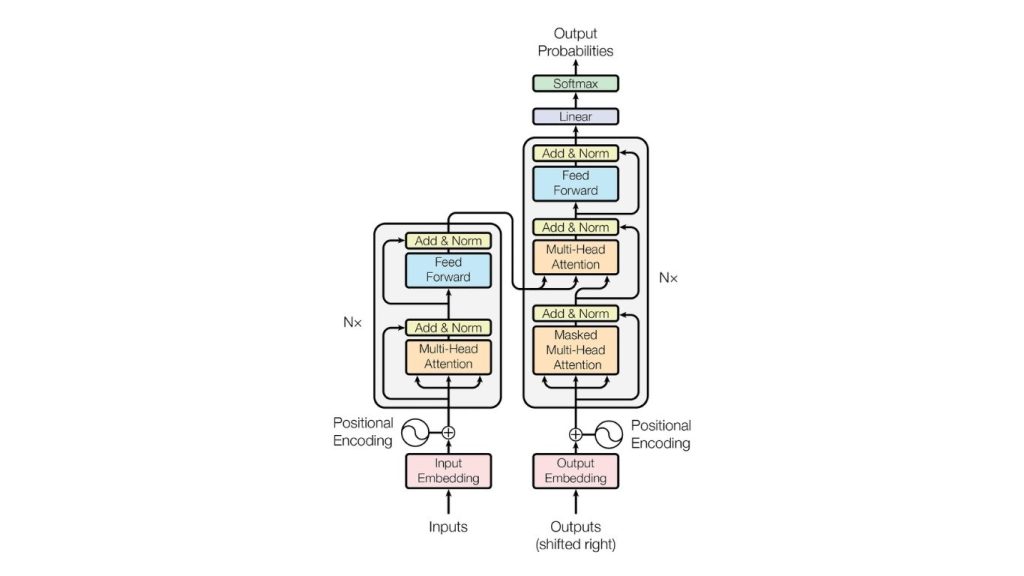

Để giải quyết vấn đề này, Transformers đã được giới thiệu. Mô hình này sử dụng kiến trúc bộ mã hóa – bộ giải mã và cho phép dữ liệu đầu vào được xử lý song song. Khác với RNN, nơi dữ liệu được đưa vào từng từ một theo thời gian, Transformers không có khái niệm mốc thời gian cho đầu vào. Thay vào đó, toàn bộ câu được đưa vào cùng lúc và embedding của tất cả các từ được tạo ra đồng thời.

Ví dụ, trong bài toán dịch tiếng Anh sang tiếng Pháp, Transformers cho phép xử lý toàn bộ câu đầu vào cùng một lúc, thay vì xử lý từng từ một như trong RNN.

Máy tính xử lý các con số và vector, chứ không xử lý từ ngữ. Để biểu diễn từ ngữ, máy tính sử dụng một kỹ thuật gọi là “word embedding”, trong đó mỗi từ được ánh xạ thành một điểm trong không gian vector, gọi là không gian embedding. Một không gian embedding đã được huấn luyện sẵn được sử dụng để ánh xạ mỗi từ thành một vector. Tuy nhiên, cùng một từ trong những ngữ cảnh khác nhau có thể mang những ý nghĩa khác nhau.

Embedding nắm bắt ngữ cảnh của một từ dựa trên vị trí của nó trong câu. Bằng cách kết hợp embedding đầu vào với mã hóa vị trí, các embedding thu được sẽ chứa thông tin ngữ cảnh. Các embedding này sau đó được đưa vào bộ mã hóa, bao gồm một lớp chú ý đa đầu và một lớp truyền thẳng. Lớp chú ý được sử dụng để xác định những phần nào của câu đầu vào là quan trọng để mô hình tập trung vào. Trong quá trình huấn luyện, bộ giải mã được cung cấp embedding của câu tiếng Pháp tương ứng, bao gồm ba thành phần chính.

Cơ chế tự chú ý trong các mạng Transformer tạo ra các vector chú ý cho từng từ trong câu, cho biết mức độ liên quan của mỗi từ đối với tất cả các từ khác trong cùng một câu. Các vector chú ý này cùng với các vector đầu ra của bộ mã hóa sau đó được xử lý bởi khối chú ý giữa bộ mã hóa và bộ giải mã, khối này đánh giá mối quan hệ giữa từng vector từ.

Khối này chịu trách nhiệm cho việc ánh xạ từ tiếng Anh sang tiếng Pháp. Một sự thay đổi quan trọng về kiến trúc đã được đưa ra khi thay thế các mạng nơ-ron hồi quy bằng mô hình Transformer. Không giống như mạng nơ-ron hồi quy, mô hình Transformer sử dụng tính toán song song và có cơ chế tự chú ý giúp giữ lại các thông tin quan trọng, qua đó loại bỏ các vấn đề về xử lý dữ liệu tuần tự và sự mất mát thông tin vốn tồn tại trong mạng nơ-ron hồi quy.

GPT

GPT là một mô hình ngôn ngữ sử dụng huấn luyện sinh (generative training) và không yêu cầu dữ liệu gán nhãn trong quá trình huấn luyện. Mô hình này hoạt động bằng cách dự đoán xác suất xuất hiện của một chuỗi từ trong ngôn ngữ. Hiện nay GPT có ba phiên bản chính gồm GPT-1, GPT-2 và GPT-3, cụ thể:

- Mô hình GPT-1 trải qua quy trình huấn luyện gồm hai giai đoạn. Giai đoạn đầu là tiền huấn luyện không giám sát trên một tập dữ liệu lớn chưa được gán nhãn, dựa trên mục tiêu của mô hình ngôn ngữ. Giai đoạn tiếp theo là tinh chỉnh có giám sát, trong đó mô hình được huấn luyện cho một tác vụ cụ thể bằng dữ liệu chuyên biệt cho tác vụ đó. GPT-1 được xây dựng dựa trên kiến trúc bộ giải mã của Transformer.

- GPT-2 tập trung vào tạo sinh văn bản. Mô hình sử dụng cơ chế tự hồi quy và được huấn luyện trên các chuỗi đầu vào với mục tiêu dự đoán token tiếp theo tại mỗi thời điểm trong chuỗi. GPT-2 được xây dựng từ các khối Transformer, tập trung mạnh vào cơ chế attention, và có số chiều tham số ít hơn so với BERT. Tuy nhiên, mô hình này lại chứa nhiều khối Transformer hơn (48 khối) và có khả năng xử lý các chuỗi dài hơn.

- Kiến trúc của GPT-3 tương tự như GPT-2, nhưng có số lượng khối Transformer lớn hơn (96 khối) và được huấn luyện trên tập dữ liệu lớn hơn. Ngoài ra, độ dài chuỗi của các câu đầu vào trong GPT-3 gấp đôi so với GPT-2, khiến GPT-3 trở thành kiến trúc mạng nơ-ron nhân tạo lớn nhất với số lượng tham số nhiều nhất.

>> Tìm hiểu thêm:

- Khả năng thị giác của Chat GPT-5 và Cách Prompt hiệu quả

- Các mô hình ngôn ngữ thị giác chạy cục bộ tốt nhất

- Tạo web bán hàng bằng AI miễn phí, chuẩn SEO, hiệu quả nhất

Ứng dụng thực tế của mạng nơ-ron nhân tạo

Mạng nơ-ron nhân tạo đã phát triển vượt xa các ứng dụng ban đầu, giải quyết những thách thức phức tạp nhất trong lĩnh vực tính toán hiện đại. Từ các nhiệm vụ đơn giản như phát hiện thư rác cho đến những công nghệ tiên tiến hỗ trợ đời sống hàng ngày, mạng nơ-ron nhân tạo đóng vai trò là trung tâm của nhiều đổi mới trong các ngành công nghiệp từ giải trí đến y tế.

Thị giác máy tính và phân loại hình ảnh

Các mạng như mạng nơ-ron tích chập (CNN) được thiết kế để xử lý dữ liệu hình ảnh và có thể phân biệt đối tượng, con người và bối cảnh với độ chính xác rất cao.

Ví dụ:

- Hệ thống nhận diện khuôn mặt – xác định danh tính dựa trên các đặc trưng khuôn mặt riêng biệt

- Xe tự lái – phát hiện chướng ngại vật, người đi bộ và các phương tiện khác trên đường

- Phân tích hình ảnh y tế – phát hiện các bất thường như khối u trong ảnh X-quang, MRI và CT, đôi khi với độ chính xác còn cao hơn bác sĩ

- Phân tích khung hình video – được sử dụng trong phân tích thể thao (theo dõi chuyển động cầu thủ) và hệ thống giám sát

Xử lý ngôn ngữ tự nhiên (NLP)

Khả năng của các mô hình như Transformers (bao gồm BERT và GPT) trong việc hiểu ngữ cảnh và tạo ra văn bản giống con người đã tạo ra một cuộc cách mạng trong cách máy móc tương tác với ngôn ngữ.

Ví dụ:

- Chatbot và trợ lý ảo (như Siri hoặc Alexa)

- Công cụ phân tích cảm xúc để đánh giá ý kiến thể hiện trong đánh giá của khách hàng hoặc các bài đăng trên mạng xã hội

Hệ thống gợi ý

Mạng nơ-ron nhân tạo được sử dụng rộng rãi để dự đoán những sản phẩm, bộ phim hoặc bản nhạc mà người dùng có thể yêu thích, dựa trên sở thích trong quá khứ.

Ví dụ:

- Netflix và Spotify sử dụng mạng nơ-ron để đề xuất nội dung phù hợp với từng cá nhân

- Các website thương mại điện tử và tiếp thị qua email sử dụng mạng nơ-ron để gợi ý sản phẩm dựa trên lịch sử duyệt web và mua hàng của bạn

Ngoài ra, mạng nơ-ron nhân tạo ngày càng được ứng dụng trong các lĩnh vực như nhận dạng giọng nói, bảo trì dự đoán, phát hiện gian lận, phát hiện bất thường và dự báo tài chính, cho thấy tính linh hoạt của chúng trên nhiều ngành nghề khác nhau. Mạng nơ-ron nhân tạo thậm chí còn hỗ trợ trong lĩnh vực nghệ thuật như sáng tác nhạc, làm thơ hoặc hỗ trợ thiết kế.

>>> Tìm hiểu thêm:

- Phrase Grounding là gì? Mô hình và cách hoạt động

- Visual Question Answering là gì? Mô hình và Phương pháp hoạt động

- Các công cụ thị giác máy tính không cần code hàng đầu năm 2026

Kết luận

Mỗi kiến trúc mạng nơ-ron nhân tạo đều sở hữu những ưu điểm và giới hạn riêng, phù hợp với từng loại dữ liệu và mục tiêu bài toán. Mạng nơ-ron truyền thẳng thường được áp dụng hiệu quả cho các bài toán dữ liệu có cấu trúc như phân loại và hồi quy, trong khi mạng nơ-ron hồi quy phát huy thế mạnh trong việc xử lý dữ liệu dạng chuỗi như văn bản, âm thanh hay video. Đáng chú ý, các nghiên cứu gần đây cho thấy mạng Transformer, với cơ chế attention, đã vượt trội hơn RNN trong nhiều lĩnh vực và trở thành nền tảng của nhiều mô hình tiên tiến hiện nay.

Việc hiểu rõ Neural Network là gì, cũng như đặc điểm của từng kiến trúc, không chỉ giúp lựa chọn mô hình phù hợp mà còn là cơ sở quan trọng để xây dựng và phát triển các hệ thống trí tuệ nhân tạo hiệu quả trong thực tế.

>>> Nguồn tham khảo: What is a Neural Network & How Does It Work? AI Guide

TOT là đơn vị tiên phong trong hành trình chuyển đổi số. Chúng tôi mang đến giải pháp thiết kế website, mobile app và viết phần mềm theo yêu cầu với dịch vụ linh hoạt, tối ưu theo đúng nhu cầu của doanh nghiệp.

Lấy cảm hứng từ triết lý “Công nghệ vì con người”, TOT giúp doanh nghiệp vận hành hiệu quả hơn, nâng tầm trải nghiệm khách hàng và tạo dấu ấn bền vững cho thương hiệu.

Thông tin liên hệ TopOnTech (TOT):

📞 Hotline/WhatsApp/Zalo: 0906 712 137

✉️ Email: long.bui@toponseek.com🏢 Địa chỉ:31 Đường Hoàng Diệu, Phường Xóm Chiếu, TP. Hồ Chí Minh, Việt Nam