YOLO (viết tắt của You Only Look Once) là một họ các mô hình thị giác máy tính đã thu hút sự quan tâm rất lớn kể từ khi Joseph Redmon, Santosh Divvala, Ross Girshick và Ali Farhadi giới thiệu kiến trúc mới này vào năm 2016 tại CVPR (Hội nghị Thị giác máy tính và nhận dạng mẫu), thậm chí còn nhận được Giải thưởng do cộng đồng QpenCV bình chọn.

Vậy chính xác thì họ mô hình YOLO trong thị giác máy tính là gì? YOLO bắt nguồn từ đâu, điều gì khiến nó trở nên mới mẻ và vì sao lại có nhiều phiên bản YOLO đến như vậy? Hãy cùng tìm hiểu chi tiết qua bài viết sau.

>>> Tìm hiểu thêm:

- Top 5 trình soạn thảo mã cho thị giác máy tính tốt nhất

- Suy Luận Trong Thị Giác Máy Tính: Cách Thực Hiện & Triển Khai Mô Hình AI

- Đếm Đối Tượng Bằng Thị Giác Máy Tính

- Cách tạo chatbot AI bán hàng đa kênh hiệu quả, chi tiết

Nguồn gốc của YOLO

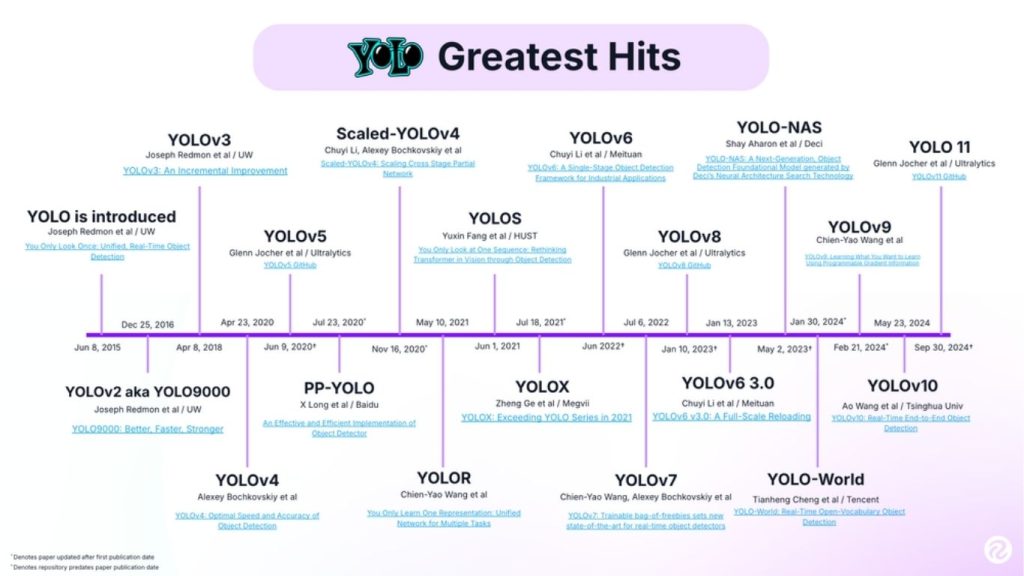

Phiên bản YOLO đầu tiên được viết bởi Joseph Redmon trên một nền tảng tùy chỉnh có tên là Darknet. Darknet là một nền tảng nghiên cứu rất linh hoạt, được viết bằng các ngôn ngữ lập trình mức thấp. Từ nền tảng này đã tạo ra hàng loạt các bộ object detection (phát hiện đối tượng) thời gian thực hàng đầu trong lĩnh vực thị giác máy tính, bao gồm: YOLO, YOLOv2, YOLOv3, YOLOv4, YOLOv5, YOLOV6, YOLOV7, YOLOv8, YOLO-NAS, YOLO-World, YOLOv9, YOLOv10, YOLOv11 và YOLOv12.

Họ mô hình YOLO đã không ngừng phát triển kể từ lần phát hành đầu tiên vào năm 2016. Đáng chú ý, YOLO phiên bản 2 và YOLO phiên bản 3 đều do chính Joseph Redmon phát triển. Các mô hình sau phiên bản 3 được xây dựng bởi những tác giả khác, và thay vì được coi là các bản phát hành nối tiếp trực tiếp, mỗi phiên bản lại có mục tiêu và định hướng riêng tùy theo nhóm phát triển.

Mô hình YOLO ban đầu là mạng phát hiện đối tượng đầu tiên kết hợp việc vẽ hộp giới hạn và xác định nhãn phân loại trong một mạng duy nhất, huấn luyện từ đầu đến cuối.

Một số object detection models (mô hình phát hiện đối tượng) xem quá trình phát hiện là bài toán gồm hai bước:

- Bước 1: Xác định các vùng có khả năng chứa đối tượng (hộp giới hạn).

- Bước 2: Phân loại đối tượng trong từng vùng đó.

Cách tiếp cận này được gọi là bộ phát hiện hai giai đoạn, và các mô hình phổ biến như Faster R-CNN sử dụng phương pháp này.

>> Xem thêm: Data Annotation Platforms: Nền tảng gán nhãn dữ liệu cho thị giác máy tính tốt nhất

So sánh các mô hình YOLO

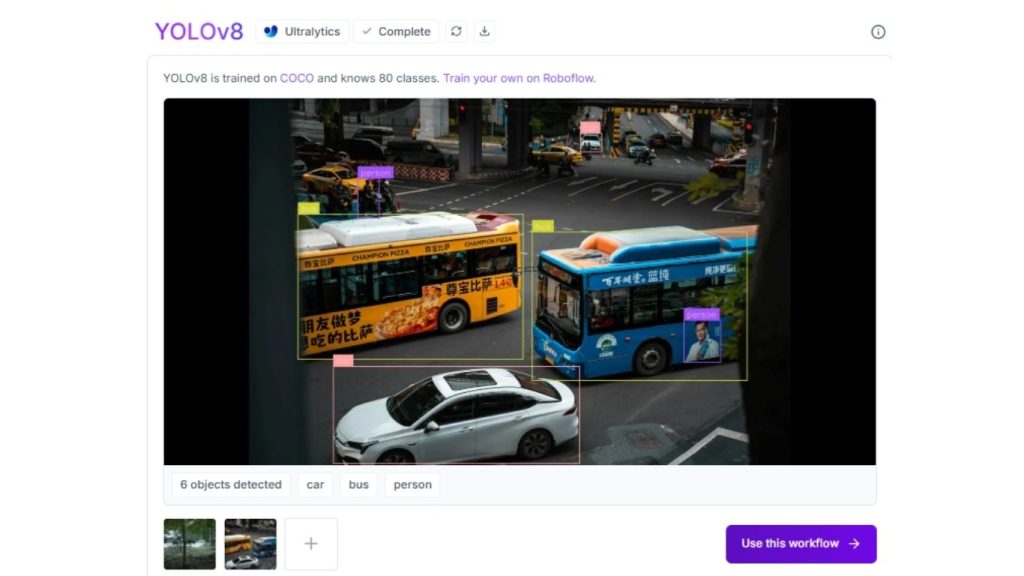

Roboflow đã xây dựng một môi trường thử nghiệm mô hình tương tác cho phép so sánh nhiều mô hình YOLO khác nhau. Môi trường này được cấu hình để sử dụng các điểm kiểm tra cơ sở được huấn luyện trên bộ dữ liệu COCO của Microsoft cho các phiên bản YOLO 8, YOLO 9, YOLO 10 và YOLO 11. Quy trình này có thể phát hiện các lớp đối tượng như mèo, chó và xe hơi.

Ví dụ về bản thử nghiệm:

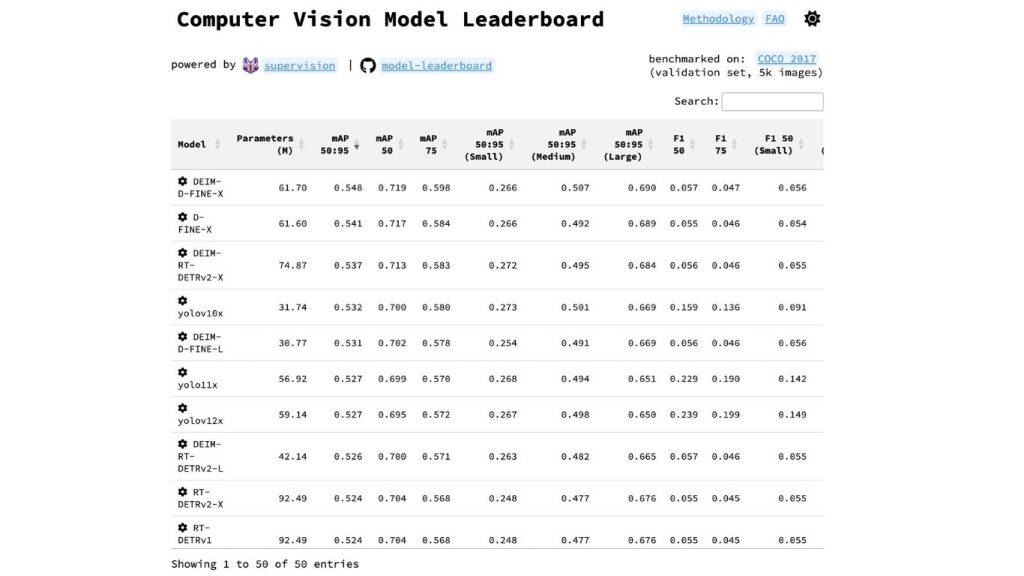

Dưới đây là bảng xếp hạng các mô hình thị giác máy tính của Roboflow đánh giá các mô hình phát hiện đối tượng phổ biến dựa trên bộ dữ liệu COCO của Microsoft (bộ dữ liệu Microsoft COCO thường được sử dụng để đánh giá và so sánh hiệu suất của các mô hình phát hiện đối tượng).

Dự án này là mã nguồn mở, với toàn bộ mã nguồn có sẵn được sử dụng cho việc đánh giá hiệu năng. Điều này cho phép người dùng kiểm chứng kết quả trong bảng xếp hạng để hiểu rõ hiệu năng tương đối giữa các mô hình YOLO

>> Tìm hiểu thêm:

- Cách tạo prompt cho LLM trong thị giác máy tính tăng độ chính xác

- Computer Vision Software: Các phần mềm thị giác máy tính miễn phí

- Các công cụ thị giác máy tính tốt nhất: Lời khuyên về các thư viện tốt nhất & nhiều hơn nữa

Thuật toán và kiến trúc YOLO

YOLO là một bộ phát hiện một giai đoạn, xử lý đồng thời việc xác định vị trí và phân loại đối tượng chỉ trong một lần truyền qua mạng. YOLO không phải là mô hình một giai đoạn duy nhất (ví dụ: MobileNetSSDv2 là một mô hình phát hiện một lần bắn phổ biến khác), nhưng nhìn chung nó vượt trội hơn về cả tốc độ lẫn độ chính xác.

Bằng cách xem nhiệm vụ phát hiện như một phương pháp hồi quy một lần để xác định hộp giới hạn, các mô hình YOLO thường rất nhanh và có kích thước nhỏ gọn, giúp quá trình huấn luyện nhanh hơn và triển khai dễ dàng hơn, đặc biệt trên các thiết bị biên có tài nguyên tính toán hạn chế.

Các mô hình YOLO được sử dụng để làm gì?

Thuật toán YOLO được sử dụng cho các bài toán phát hiện đối tượng theo thời gian thực. Trước khi YOLO ra đời, các mô hình dựa trên R-CNN là phương pháp phổ biến nhất để phát hiện đối tượng, nhưng chúng thường chậm và không phù hợp với các ứng dụng yêu cầu phản hồi theo thời gian thực.

YOLO cung cấp tốc độ suy luận cần thiết cho các tình huống yêu cầu suy luận nhanh như phát hiện xe cộ, nhận diện động vật và giám sát vi phạm an toàn.

Dưới đây là một số ứng dụng khác của YOLO bao gồm:

- Xác định kẻ xâm nhập trong nhà máy

- Giám sát chuyển động của phương tiện trên công trường xây dựng

- Phân tích lưu lượng giao thông trên đường (Ví dụ: xác định thời gian đường được sử dụng nhiều nhất và ít nhất)

- Phát hiện khói từ các đám cháy rừng trong tự nhiên

- Giám sát việc tuân thủ trang bị bảo hộ lao động (PPE) trong môi trường nguy hiểm (Ví dụ: khi sử dụng công cụ hoặc làm việc với hóa chất phát ra khí độc hại)

Các trường hợp sử dụng của YOLO rất đa dạng. Nếu bạn cần triển khai camera để phát hiện đối tượng theo thời gian thực, YOLO luôn là một lựa chọn đáng cân nhắc.

>> Tham khảo thêm:

- Phrase Grounding là gì? Mô hình và cách hoạt động

- Cách so sánh các mô hình thị giác máy tính một cách trực quan

- Tạo web bán hàng bằng AI miễn phí, chuẩn SEO, hiệu quả nhất

Mô hình YOLO: Các phiên bản và quá trình phát triển

YOLOv2

YOLO phiên bản 2 được phát hành năm 2017 và nhận được ghi nhận danh dự tại CVPR năm 2017. Kiến trúc này giới thiệu nhiều cải tiến so với phiên bản ban đầu, bao gồm chuẩn hóa theo lô, độ phân giải cao hơn và hộp neo.

YOLOv3

YOLO phiên bản 3 được phát hành năm 2018. (Bài báo về YOLOv3 được xem là một trong những bài báo dễ đọc nhất trong lĩnh vực thị giác máy tính nhờ cách trình bày gần gũi).

Phiên bản này bổ sung điểm xác suất tồn tại đối tượng cho dự đoán hộp giới hạn, thêm các kết nối với mạng xương sống và thực hiện dự đoán ở ba mức độ phân giải khác nhau để cải thiện khả năng phát hiện đối tượng nhỏ.

Sau khi ra mắt YOLOv3, Joseph Redmon đã rút lui khỏi nghiên cứu về thị giác máy tính. Các nhà nghiên cứu như Alexey Bochkovskiy và các nhà đổi mới như Glenn Jocher bắt đầu chia sẻ mã nguồn mở cho các tiến bộ của họ trong lĩnh vực thị giác máy tính. Các nhóm như Baidu cũng đã phát hành các phiên bản triển khai YOLO của riêng họ (như PP-YOLO), cho thấy sự cải thiện về mAP và giảm độ trễ.

YOLOv4

YOLOv4, được phát hành vào tháng 4 năm 2020 bởi Alexey Bochkovskiy, đã trở thành bài báo đầu tiên trong “họ YOLO” không do Joseph Redmon đồng tác giả. Mô hình này cải tiến việc tổng hợp đặc trưng, bổ sung nhiều kỹ thuật tăng cường dữ liệu và hàm kích hoạt mới.

YOLOv5

YOLOv5 chỉ yêu cầu cài đặt torch và một số thư viện Python nhẹ. Các mô hình YOLOv5 được đào tạo cực kỳ nhanh chóng, giúp giảm chi phí thử nghiệm khi bạn xây dựng mô hình của mình. Bạn có thể thực hiện suy luận với YOLOv5 trên hình ảnh đơn lẻ, hình ảnh theo lô, luồng video hoặc cổng webcam và dễ dàng chuyển đổi YOLOv5 từ trọng số PyTorch sang trọng số ONXX sang CoreML sang iOS.

>> Tìm hiểu thêm: Top 5 thư viện Python cho thị giác máy tính [2026]

PP-YOLO

PP-YOLO, được Baidu phát hành vào tháng 8 năm 2020, vượt trội hơn YOLOv4 về các chỉ số hiệu suất trên tập dữ liệu COCO. “PP” là viết tắt của “PaddlePaddle”, khung mạng thần kinh của Baidu (tương tự như TensorFlow của Google). PP-YOLO cải thiện hiệu suất bằng cách tận dụng các cải tiến như cấu trúc mô hình cơ bản, chính quy hóa DropBlock, Matrix NMS và nhiều hơn nữa.

Scaled YOLOv4

Scaled YOLOv4 được công bố vào tháng 11 năm 2020 bởi Chien-Yao Wang, Alexey Bochkovskiy và Hong-Yuan Mark Liao. Mô hình này tận dụng mạng lưới Cross Stage Partial để mở rộng quy mô mạng lưới đồng thời duy trì cả độ chính xác và tốc độ của YOLOv4. Đáng chú ý, Scaled YOLOv4 tận dụng khung đào tạo được phát hành trong YOLOv5.

PP-YOLOv2

PP-YOLOv2, một lần nữa do nhóm Baidu phát triển, được phát hành vào tháng 4 năm 2021. PP-YOLOv2 đã thực hiện một số điều chỉnh nhỏ đối với PP-YOLO để cải thiện hiệu suất, bao gồm việc thêm hàm kích hoạt mish và Mạng Tích hợp Đường dẫn (có thể nhận thấy xu hướng cải tiến từ mạng này sang mạng khác).

YOLOv6

YOLOv6 cải tiến khung cơ sở và phần cổ của YOLO bằng cách thiết kế lại chúng với sự tối ưu hóa cho phần cứng – giới thiệu hai thành phần mới được gọi là EfficientRep Backbone và Rep-PAN Neck.

Trong YOLOv6, phần đầu được tách rời, nghĩa là mạng có các lớp bổ sung tách biệt các tính năng này khỏi phần đầu cuối cùng, điều này đã được chứng minh là tăng hiệu suất. Ngoài các thay đổi kiến trúc, kho lưu trữ YOLOv6 còn thực hiện một số cải tiến trong quy trình đào tạo, bao gồm đào tạo không sử dụng anchor (không phải NMS), gán nhãn SimOTA và hàm mất mát hồi quy hộp SIoU.

YOLOv7

Trong YOLOv7, các tác giả đã phát triển dựa trên các nghiên cứu trước đây về chủ đề này, đồng thời xem xét lượng bộ nhớ cần thiết để lưu trữ các lớp trong bộ nhớ và khoảng cách mà gradient phải truyền ngược qua các lớp – gradient càng ngắn, mạng thần kinh của họ càng có khả năng học tập mạnh mẽ hơn. Lớp tổng hợp cuối cùng mà họ lựa chọn là E-ELAN, một phiên bản mở rộng của khối tính toán ELAN.

YOLOv8

YOLOv8 được phát triển bởi Ultralytics, công ty cũng đã tạo ra mô hình YOLOv5 có ảnh hưởng lớn và định hình ngành công nghiệp. YOLOv8 bao gồm nhiều thay đổi và cải tiến về kiến trúc và trải nghiệm phát triển so với YOLOv5. YOLOv8 đi kèm với nhiều tính năng tiện lợi cho nhà phát triển, từ giao diện dòng lệnh (CLI) dễ sử dụng đến gói Python được cấu trúc tốt.

YOLOv8 là một mô hình không sử dụng khung tham chiếu (anchor-free). Điều này có nghĩa là nó dự đoán trực tiếp vị trí trung tâm của đối tượng thay vì khoảng cách từ khung tham chiếu đã biết.

>> Tham khảo thêm: Xây dựng ứng dụng phát hiện đối tượng bằng Python chỉ trong vài phút với Roboflow

YOLO-NAS

YOLO-NAS, do Deci AI phát triển, đã vượt trội so với các phiên bản tiền nhiệm – đặc biệt là YOLOv6 và YOLOv8, bằng cách đạt được giá trị mAP cao hơn trên bộ dữ liệu COCO đồng thời duy trì độ trễ thấp hơn. YOLO-NAS cũng là mô hình tốt nhất trên bộ dữ liệu Roboflow 100, cho thấy khả năng tinh chỉnh dễ dàng trên bộ dữ liệu tùy chỉnh.

Công nghệ Tìm kiếm Kiến trúc Mạng Thần kinh (Neural Architecture Search) độc quyền của Deci đã tạo ra mô hình YOLO-NAS. Công cụ này cho phép bạn nhập bất kỳ tác vụ, đặc điểm dữ liệu (không yêu cầu truy cập dữ liệu), môi trường suy luận và mục tiêu hiệu suất, sau đó hướng dẫn bạn tìm kiếm kiến trúc tối ưu mang lại sự cân bằng tốt nhất giữa độ chính xác và tốc độ suy luận cho ứng dụng cụ thể của bạn.

YOLO-World

YOLO-World là mô hình phát hiện đối tượng thời gian thực, không cần huấn luyện (zero-shot) do Phòng Thí nghiệm Trí tuệ Nhân tạo (AI Lab) của Tencent phát triển. Vì YOLO-World là mô hình zero-shot, bạn có thể cung cấp các lệnh văn bản cho mô hình để xác định các đối tượng quan tâm trong hình ảnh mà không cần huấn luyện hoặc tinh chỉnh mô hình.

YOLO-World đã giới thiệu một phương pháp mới trong phát hiện đối tượng: “nhập lệnh rồi phát hiện”. Điều này loại bỏ nhu cầu mã hóa văn bản theo thời gian thực, một đặc điểm của các mô hình zero-shot khác làm giảm tốc độ tiềm năng của mô hình. Theo bài báo YOLO World, phiên bản nhỏ của mô hình đạt tới 74,1 FPS trên GPU V100.

YOLOv9

Vào ngày 21 tháng 2 năm 2024, Chien-Yao Wang, I-Hau Yeh và Hong-Yuan Mark Liao đã công bố bài báo “YOLOv9: Học những gì bạn muốn học bằng thông tin gradient có thể lập trình”, giới thiệu một kiến trúc mô hình thị giác máy tính mới: YOLOv9. Mã nguồn đã được công bố, cho phép bất kỳ ai cũng có thể đào tạo mô hình YOLOv9 của riêng mình.

Theo nhóm nghiên cứu dự án, YOLOv9 đạt được điểm mAP cao hơn so với các mô hình YOLO phổ biến hiện có như YOLOv8, YOLOv7 và YOLOv5 khi được đánh giá trên bộ dữ liệu MS COCO.

YOLOv10

Được phát hành vào ngày 23 tháng 5 năm 2024, YOLOv10 là mô hình phát hiện đối tượng thời gian thực được phát triển bởi các nhà nghiên cứu từ Đại học Thanh Hoa. YOLOv10 đại diện cho công nghệ tiên tiến nhất trong lĩnh vực phát hiện đối tượng, đạt được độ trễ thấp hơn so với các mô hình YOLO trước đó với ít tham số hơn.

Về hiệu suất, bài báo YOLOv10 ghi chú: “Mô hình YOLOv10-S của chúng tôi nhanh hơn 1,8 lần so với RT-DETR-R18 trên cùng mức AP trên COCO, đồng thời có số tham số và FLOPs ít hơn 2,8 lần. So với YOLOv9-C, YOLOv10-B có độ trễ thấp hơn 46% và số tham số ít hơn 25% cho cùng mức hiệu suất.”

YOLOv11

YOLOv11 là kiến trúc mô hình thị giác máy tính được phát triển bởi Ultralytics, nhóm phát triển các mô hình YOLOv5 và YOLOv8. YOLOv11 hỗ trợ phát hiện đối tượng, phân đoạn, phân loại, phát hiện điểm chính và phát hiện hộp giới hạn có hướng (OBB).

Mô hình YOLOv11x – mô hình lớn nhất trong series, được báo cáo đạt điểm mAP 54,7% khi đánh giá trên bộ dữ liệu Microsoft COCO. Mô hình nhỏ nhất – YOLOv11n, được báo cáo đạt điểm mAP 39,5% khi đánh giá trên cùng bộ dữ liệu.

YOLOv12

Được phát hành vào ngày 18 tháng 2 năm 2025, YOLOv12 là một kiến trúc mô hình thị giác máy tính tiên tiến nhất. YOLOv12 được phát triển bởi các nhà nghiên cứu Yunjie Tian, Qixiang Ye, David Doermann và được giới thiệu trong bài báo “YOLOv12: Attention-Centric Real-Time Object Detectors”. YOLOv12 đi kèm với một phiên bản mã nguồn mở mà bạn có thể sử dụng để tinh chỉnh mô hình.

Mô hình đạt được cả độ trễ thấp hơn và điểm mAP cao hơn khi được đánh giá trên bộ dữ liệu Microsoft COCO.

YOLO 26

YOLO26 là một mô hình end-to-end, tối ưu hóa cho thiết bị biên, hỗ trợ năm tác vụ chính trong xử lý hình ảnh: phát hiện đối tượng, phân đoạn đối tượng, ước lượng tư thế, phát hiện đối tượng có định hướng (OBB) và phân loại hình ảnh. Nền tảng này này cung cấp chức năng toàn diện cho tất cả các tác vụ này, cho phép người dùng thực hiện đào tạo, kiểm tra, suy luận và xuất mô hình một cách liền mạch cho mọi biến thể mô hình.

YOLO26 đạt độ chính xác cao nhất trong dòng mô hình YOLO, nhưng độ chính xác của nó không vượt qua RF-DETR về mặt độ chính xác.

>>> Tìm hiểu thêm:

- Xây Dựng Mô Hình Ngôn Ngữ Thị Giác với Next.js & Roboflow

- Các mô hình ngôn ngữ thị giác chạy cục bộ tốt nhất

- Hướng dẫn triển khai AI trong ứng dụng di động đơn giản

Vì sao nên sử dụng mô hình YOLO?

Mô hình YOLO được ưa chuộng vì các lý do như sau:

- Thứ nhất, mô hình YOLO có tốc độ xử lý rất nhanh, cho phép suy luận trên luồng video với tốc độ khung hình cao. Nhờ đó, YOLO đặc biệt phù hợp cho các bài toán suy luận thời gian thực từ camera, chẳng hạn như theo dõi các đối tượng di chuyển nhanh như quả bóng trên sân bóng đá hoặc các gói hàng trên băng chuyền.

- Thứ hai, mô hình YOLO tiếp tục dẫn đầu về độ chính xác. Mô hình YOLOv7, phiên bản mới nhất trong gia đình mô hình tính đến tháng 11 năm 2022, có hiệu suất hàng đầu khi so sánh với bộ dữ liệu phát hiện đối tượng MS COCO. Mặc dù có nhiều mô hình khác cũng rất tốt, YOLO vẫn được biết đến với độ chính xác cao.

- Thứ ba, họ mô hình YOLO là mã nguồn mở, điều này đã tạo ra một cộng đồng lớn các nhà phát triển YOLO đang tích cực làm việc và thảo luận về các mô hình này. Điều này có nghĩa là có rất nhiều thông tin trên mạng về cách thức và lý do đằng sau các mô hình này, và việc tìm kiếm sự trợ giúp không khó nếu bạn liên hệ với cộng đồng thị giác máy tính.

Kết hợp tất cả ba yếu tố này, rõ ràng tại sao nhiều kỹ sư lại sử dụng YOLO để xây dựng các mô hình thị giác máy tính của họ.

>>> Tìm hiểu thêm:

- LLM là gì? Mô hình ngôn ngữ lớn và cách chúng hoạt động

- Vision AI Agents là gì? Cách xây dựng Vision AI Agents với Roboflow

- Deep Learning là gì? Tổng quan về cách hoạt động và ứng dụng thực tế

Kết luận

Có thể thấy, mô hình YOLO đã và đang đóng vai trò quan trọng trong sự phát triển của lĩnh vực phát hiện đối tượng thời gian thực nhờ tốc độ cao, kiến trúc hiệu quả và khả năng mở rộng linh hoạt. Với sự ra đời liên tục của nhiều phiên bản mới, mô hình YOLO không chỉ cải thiện về độ chính xác mà còn đáp ứng ngày càng tốt hơn các yêu cầu triển khai thực tế. Đây chính là lý do YOLO vẫn luôn là lựa chọn hàng đầu trong các ứng dụng thị giác máy tính hiện đại.

>>> Nguồn tham khảo: What is YOLO? The Ultimate Guide [2026]

TOT là đơn vị tiên phong trong hành trình chuyển đổi số. Chúng tôi mang đến giải pháp thiết kế website, mobile app và viết phần mềm theo yêu cầu với dịch vụ linh hoạt, tối ưu theo đúng nhu cầu của doanh nghiệp.

Lấy cảm hứng từ triết lý “Công nghệ vì con người”, TOT giúp doanh nghiệp vận hành hiệu quả hơn, nâng tầm trải nghiệm khách hàng và tạo dấu ấn bền vững cho thương hiệu.

Thông tin liên hệ TopOnTech (TOT):

📞 Hotline/WhatsApp/Zalo: 0906 712 137

✉️ Email: long.bui@toponseek.com

🏢 Địa chỉ: 31 Đường Hoàng Diệu, Phường Xóm Chiếu, TP. Hồ Chí Minh, Việt Nam